¿A qué podemos llamar bigdata personal? ¿E identidad digital?

La identidad digital se define en la actualidad por la huella que dejamos en todos los sistemas informáticos sean redes sociales, foros, etc.

Para un artista, la identidad digital se puede extender a otros conceptos más abstractos: por ejemplo, nuestra instalación THE FLY muestra la coreografía que el ratón del ordenador deja al ser manejado navegando por internet. Este baile de alguna manera también nos retrata, forma parte de nuestra identidad. Además, esta información es muy valiosa; se usa para diseñar y colocar publicidad e información en las aplicaciones (a más posibilidades de clic, más valor).

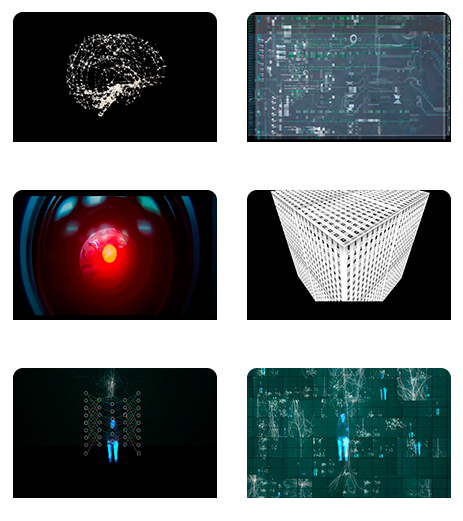

El bigdata personal es un término que nos hemos inventado para dar una idea de la proporción y cantidad de datos que podemos aportar y que ya leen las máquinas sobre nuestro comportamiento. En nuestra instalación, mostramos este hecho mediante un planteamiento estético.

La investigación en inteligencia artificial se está desarrollando en varias direcciones. Una de ellas es justo la mejora de la deducción de emociones y la incorporación del lenguaje corporal. ¿Llegarán las máquinas a simular emociones humanas?

De momento ya han aprendido a identificarlas con un alto nivel de exactitud. La computación afectiva, que es como se llama a este campo, está desarrollándose actualmente para aplicaciones de asistencia personal, en robótica, etc. No sabemos hasta dónde se va a llegar. El grado de simulación va a ser tan alto que nos preguntaremos si podemos seguir asumiendo que las emociones solo son humanas.

Los músculos o las facciones de la cara muchas veces pueden no expresar sentimientos reales. ¿Deben las máquinas saber cuándo los humanos fingen? ¿Existe un vacío en ese sentido?

Lo que los estudios de P. Ekman mostraron es que cuando actuamos de forma espontánea, las expresiones faciales son un espejo preciso de las emociones que experimentamos. Por supuesto es posible fingir, y hay personas especialmente hábiles ocultando sus emociones y alterando de manera consciente sus expresiones (por ejemplo, los actores profesionales están acostumbrados a hacerlo). Pero, por muy entrenado que se esté en fingir, es imposible evitar las micro-expresiones faciales, cambios muy rápidos que pueden durar solo unos milisegundos, ya que actúan a nivel subconsciente. Los sistemas IA deducen las emociones analizando imágenes de la cara y no ven nuestro interior (cómo nos sentimos realmente), por lo que es posible engañarles, pero son muy buenos detectando las micro-expresiones, que pueden pasar desapercibidas para el ojo humano, y sacar conclusiones.

Estos sistemas IA están aprendiendo rápido, ya que son alimentados con millones de imágenes de caras mostrando emoción. Cada vez son mejores detectando cambios sutiles de expresión y deduciendo las emociones subyacentes, pero a pesar de todo ningún sistema digital es infalible. Siempre hay errores de interpretación.

«La palabra artificial es un término cuyo origen es “ars facere”, que significa hacer arte, por lo que podemos sugerir: “IA, Inteligencia que hace Arte»

¿Cómo funciona exactamente DATA| ergo sum?

¿Cómo funciona exactamente DATA| ergo sum?